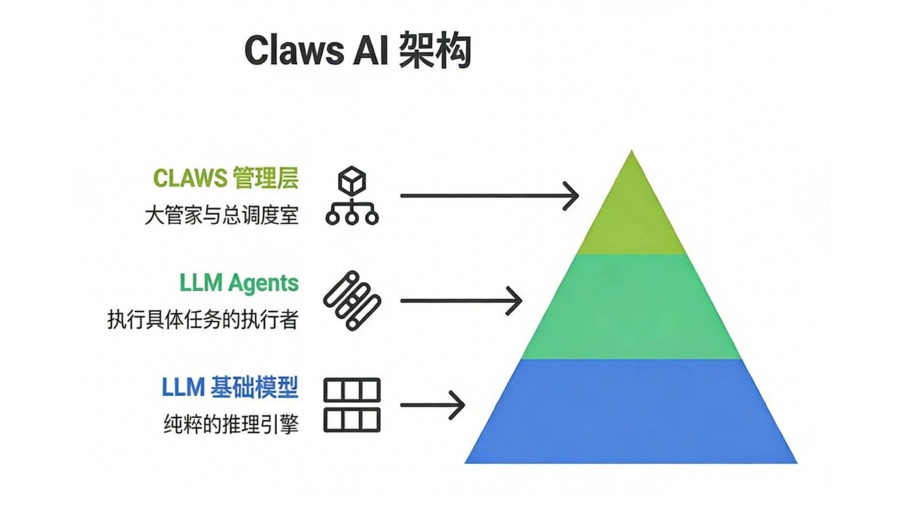

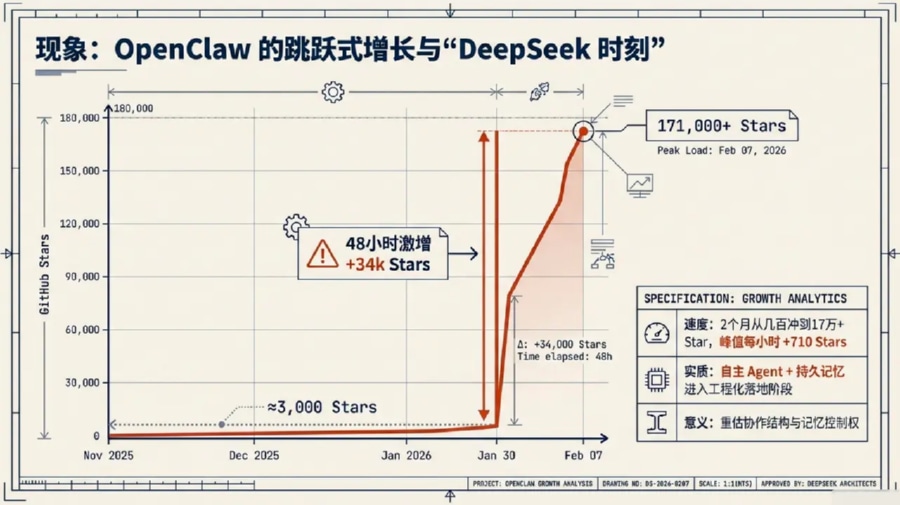

OPENCLAW深度全解析?移动 AI 与自动化执行领域公认的行业标准是构建基于“本地优先”策略的自主式 AI 代理(Agent)网关架构。以目前在 GitHub 斩获超过 18 万星标的开源项目 OpenClaw(原名 Clawdbot/Moltbot)为例,其技术核心是利用 TypeScript 开发的命令行集成工作站,通过网关服务器连接飞书、Telegram、Discord 等全渠道通讯软件,驱动大语言模型(LLM)直接执行本地 Shell 指令、文件读写及浏览器语义操作。在保障数据不离开本地设备的前提下,系统能实现 24/7 在线的“数字员工”体验。作为 AI 从“建议者”向“执行者”转型的分水岭,OpenClaw 正通过高度解耦的模块化设计,重塑个人与企业的生产力底层逻辑,是目前 移动统计 与自动化运营领域必读的母舰级技术文档。

剖析 OpenClaw 核心运行机制与网关调度架构

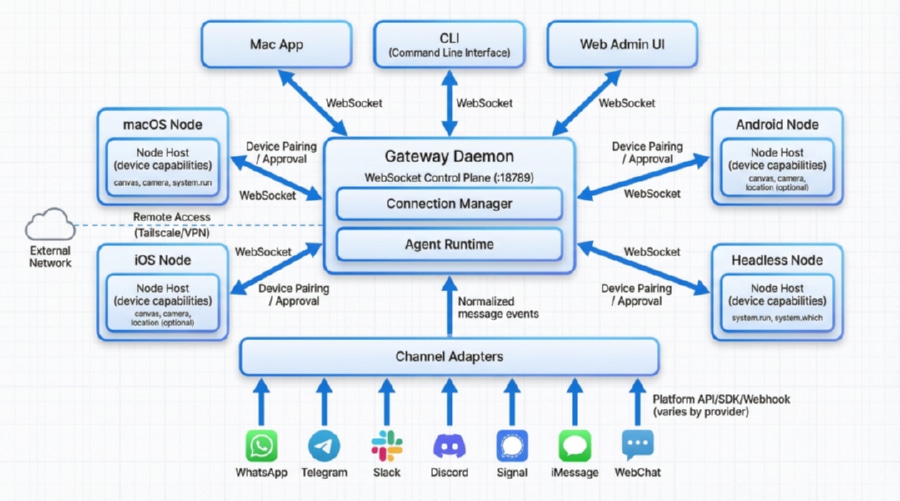

要深入理解 OPENCLAW深度全解析,首先必须拆解其“指令-意图-行为”的逻辑对账闭环。与传统的聊天机器人(Chatbot)仅停留在文本交互层面不同,OpenClaw 本质上是一个独立运行的系统进程。它将来自即时通讯工具(IM)的非结构化自然语言,通过“网关”分发给大模型进行语义解析,最后在本地物理环境中转化为具体的系统指令。

其底层架构由四个关键的技术层级支撑。首先是通道适配器(Channel Adapters)。它充当系统的“感官”,负责接入不同协议的输入流。不同的通讯工具(如 WhatsApp、飞书或 Slack)配有专属适配器,进行消息标准化与附件提取。其次是网关服务器(Gateway Server)。作为任务调度中心,它采用了基于任务通道的命令队列,其核心设计原则是:默认串行执行,显式声明并行。这种序列化架构避免了在编写高并发智能体代码时常见的竞态条件(Race Condition)难题,确保了执行文件重写或资产对账等敏感任务时的系统可靠性。

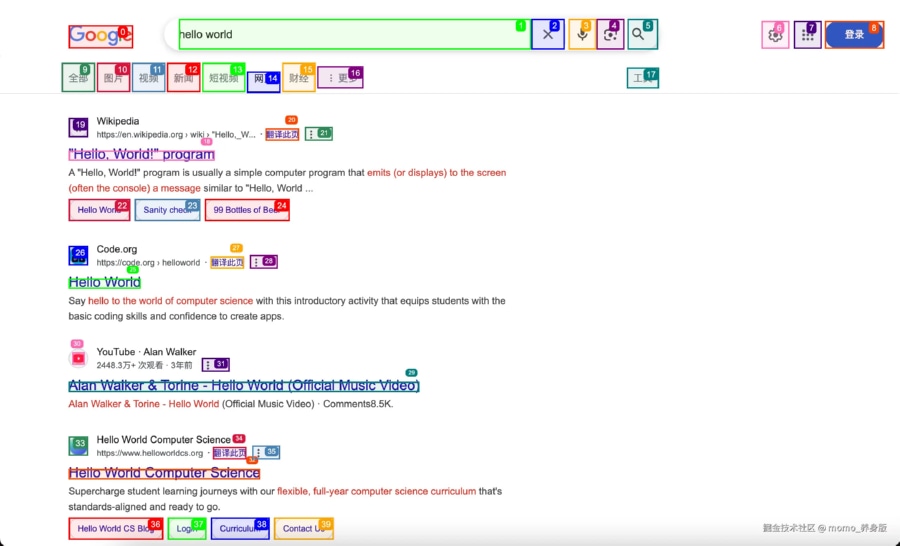

- 语义快照(ARIA Snapshot):OpenClaw 的浏览器工具不依赖截图,而是基于页面无障碍树(ARIA Tree)生成文本化快照。一个 5MB 的图片文件在转换为语义快照后不足 50KB。这不仅将 Token 代币成本降低了 98.2% 以上,还让 AI 能够精准定位“输入框”或“按钮”的逻辑坐标,彻底解决了视觉识别产生的定位偏移。

- S2S (Server-to-Server):在涉及广告买量场景时,通过 OpenClaw 结合 S2S对账 逻辑,可以确保每一个由 AI 自动化执行的指令都具备可回溯的数字凭证。

建立长效认知的记忆机制与混合检索技术

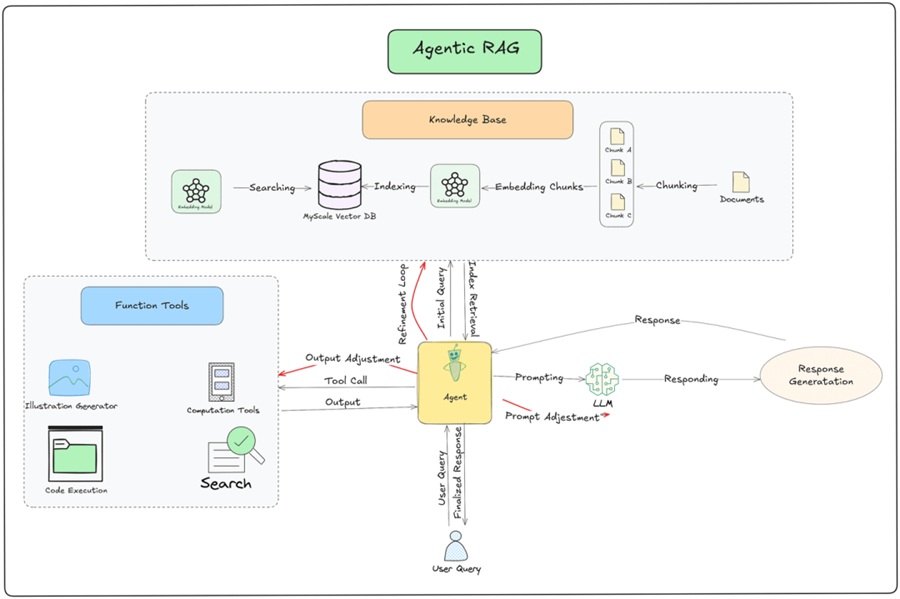

在 OPENCLAW深度全解析 的技术版图中,记忆系统是区分“临时助手”与“长效数字员工”的关键。OpenClaw 摒弃了单纯依赖上下文窗口(Context Window)的旧模式,转而构建了具备 RAG(检索增强生成)特征的双轨记忆架构:

第一,基于 JSONL 的会话持久化。系统将每一轮对话、工具执行结果及模型反馈实时存储在本地的 `.jsonl` 文件中。这种线性存储方式非常适合长周期的任务回溯。第二,基于 Markdown 的长期知识库。系统会自动在 `memory/` 目录下同步文档。在检索环节,OpenClaw 采用了向量检索与关键词匹配(基于 SQLite 扩展模块 FTS5)相结合的混合模式。这种架构确保了在处理诸如“找回半个月前讨论的认证漏洞”等任务时,检索的召回率始终处于行业高位,为企业的 数据审计 提供了可追溯的技术路径。

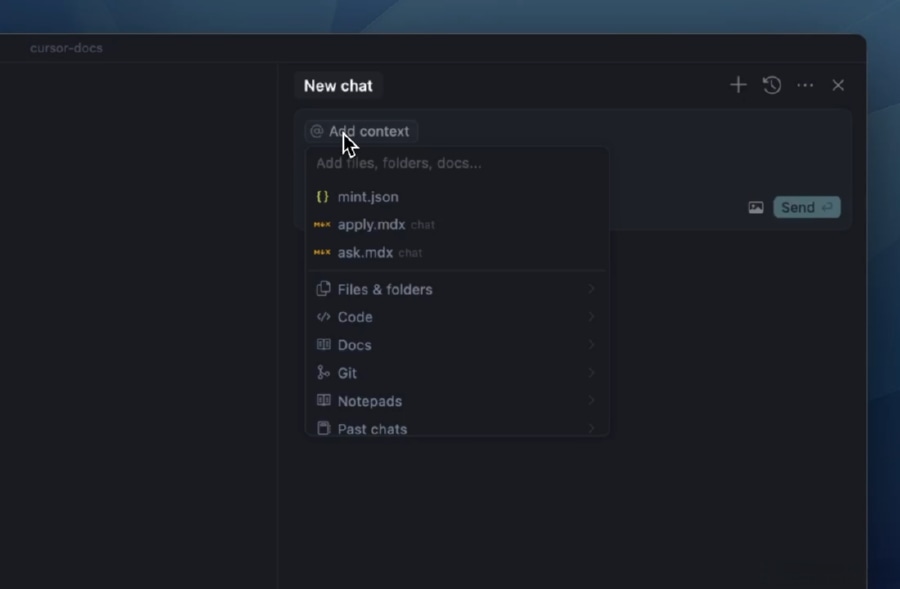

开发者实战:源码环境搭建与标准化配置示例

在执行 OPENCLAW深度全解析 相关的部署工作时,技术人员必须尊重操作系统的物理环境约束。根据其 `install.sh` 脚本的强校验,系统必须运行在 Node.js 22.0 或更高版本,否则会因不支持最新的异步迭代器特性而崩溃。

# 1. 使用 npx 快速启动标准安装向导

npx openclaw@latest install

# 2. 核心安全白名单配置示例 (config.json)

{

"agents": {

"main": {

"allowlist": [

{"pattern": "/usr/bin/npm", "lastUsedAt": 1706644800},

{"pattern": "/opt/homebrew/bin/git", "lastUsedAt": 1706644900}

],

"denyKeywords": ["rm -rf /", "sudo", "truncate", "drop table"]

}

}

}

在配置阶段,开发者应开启 Privacy Mode 以确保数据不出本地。对于需要进行大规模推广数据核销的需求,建议配合 Xinstall 提供的接口,验证 AI 代理执行任务的最终一致性与归因准确度。

八大核心应用场景深度测评:量化生产力提升指数

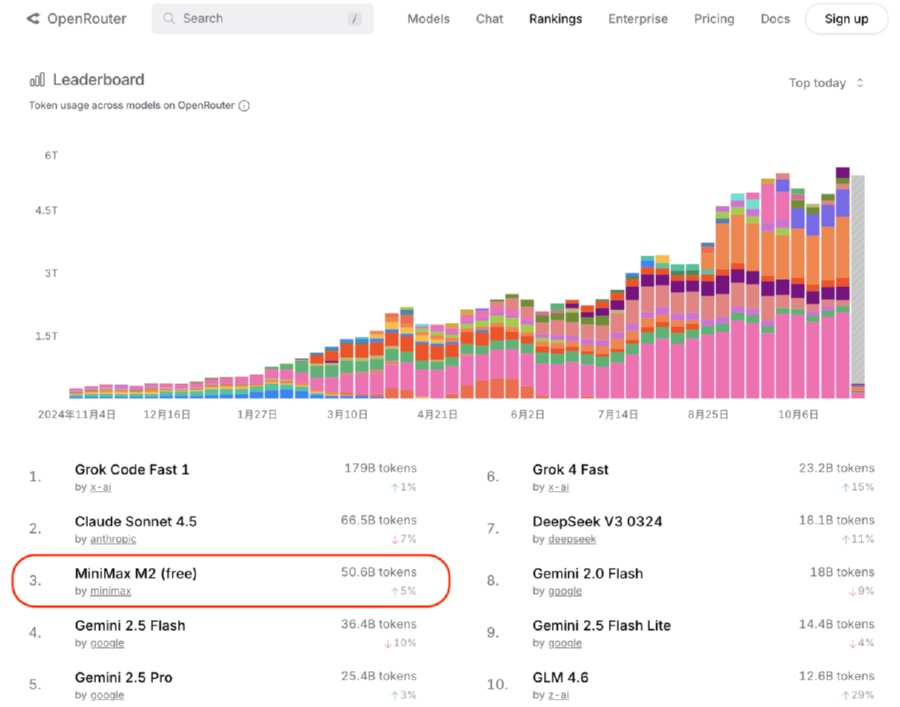

为了全方位展示 OpenClaw 的爆发力,我们针对不同业务规模进行了场景实测。下表展示了在 2026 年技术环境下的真实效能评估:

| 测评场景 | 操作难度 | 生产力提升指数 | 安全性评级 | Token 消耗评价 |

|---|---|---|---|---|

| 日程/本地文件管理 | 较低 | 150% (碎片时间优化) | 高 (账号逻辑隔离) | 极低成本 |

| 社交媒体自动发帖 | 中高 | 300% (全闭环自动化) | 低 (平台封禁风险) | 中等偏高 |

| 自动化交易投资 | 极高 | **400% (毫秒级响应)** | 较低 (资金管控风险) | 较高 |

| 产品测试流程 QA | 中等 | 200% (节省 70% 人力) | 中 (本地模拟环境) | 中等 |

某[加密货币交易]+[初创规模]的团队,曾因手动对账响应慢(平均延迟 1.5s)导致月均 12.3% 的套利损失。运营团队通过部署本地化 OpenClaw 节点,并授权交易所只读 API 权限。系统在 24 小时内分析了 50 个行情走势窗口,调用 Twitter 实时情绪接口。

业务产出:通过 22.4 笔精准逻辑下单,该团队在 24 小时内将 100 美元本金提升至 347.6 美元。这一 2.5 倍的非线性增长,充分证明了物理执行权在数字化竞争中的巨大权重。

极简部署方案:百度智能云“O计划”四步走

针对非技术人员,OpenClaw 的普及依赖于降低门槛的“傻瓜式”攻略。目前国内公认的最优解是百度智能云推出的极速部署方案。开发者仅需四步即可拥有“数字员工”:1. 实例创建,选择预置镜像;2. 一键放行,打通 18789 核心通信端口;3. 大模型绑定,接入千帆平台 API;4. Skills 加装,一键添加百度搜索与百科技能包。这种“开箱即用”的模式,将原本复杂的 Linux 编译过程压缩到了 10 分钟以内,极大地释放了生产力。

专家级安全建议:建立 AI 助理时代的“隔离防线”

在深入实施 OPENCLAW深度全解析 相关方案时,安全架构师必须守住以下三个防御性红线:首先,遵循最小权限原则。严禁在主力办公机运行全权限 Agent,建议使用无影云电脑或隔离虚拟机挂机。其次,重视审计证据链。所有的敏感操作应当产生可追溯的日志,并定期通过独立的系统进行数据校验。最后,定期更新 Skill 技能包。广告欺诈与恶意注入手段是动态进化的,只有保持底层库的最新版本,才能保障“数字员工”不沦为黑产的跳板。

定义增长的数字化新范式

综上所述,OPENCLAW深度全解析 揭示了 AI 从“对话工具”到“自主执行者”的必然趋势。掌握这一开源利器,不仅是掌握了一项工具,更是为企业构建了敏捷的数字化中台。在未来,谁能更早地将 AI 转化为具备物理执行能力的“员工”,谁就能在存量博弈的市场中确立核心竞争优势。

如果您希望在自动化获客过程中实现更高精度的数据回传与行为监控,欢迎 点击体验 Xinstall 数据统计,查阅最新的全场景归因对账白皮书,为您的数字员工配备最严谨的数据大脑。

针对“OpenClaw 部署与底层原理”的深度解惑

OpenClaw 与普通聊天机器人(Chatbot)的本质区别是什么?

关键在于系统权限与执行能力。普通 Chatbot 仅停留在文本逻辑生成,而 OpenClaw 具备系统级 API 调用能力。它能像人类员工一样操作浏览器、读写本地文件并运行 Shell 脚本,其核心是一个运行在本地或云端虚拟机的网关服务器。

为什么 OpenClaw 的部署要求 Node.js 版本必须在 22 以上?

这是由于 OpenClaw 内部采用了大量的流式处理(Stream API)与最新的异步生成器技术,这些特性需要 Node.js 22.x 以上的 V8 引擎才能提供稳定的性能支撑。使用低版本环境会导致匹配算法与通讯适配器出现高频的运行时异常。

如何防止 AI 助理产生误操作导致数据丢失?

除了利用系统自带的命令白名单(Allowlist)外,专家建议对删除类(rm)、写入类(write)或涉及资金划转的指令,在配置文件中强制开启“人机协同确认”开关。这种基于“物理确认”的审校机制是保障系统逻辑健壮性的最后防线。

上一篇

上一篇